Introdução: A urgência regulamentar e o freio político

A Inteligência Artificial (IA) deixou de ser uma promessa futurista para se tornar uma força motriz da economia e da sociedade, exigindo um arcabouço legal robusto para mitigar riscos e fomentar a inovação. No Brasil, o Projeto de Lei (PL) 2.338/2023, que visa estabelecer o Marco Legal da IA, emergiu como a principal resposta legislativa a essa necessidade. Contudo, a expectativa de uma votação célere em 2025 foi frustrada. Em um movimento que surpreendeu o ecossistema de tecnologia e a sociedade civil, a votação do texto foi oficialmente adiada para fevereiro de 2026, conforme noticiado pelo Desinformante .

Este adiamento não é apenas uma questão de calendário; ele reflete a profundidade dos impasses políticos e a intensidade das críticas técnicas que cercam o projeto. A decisão, alinhada entre as presidências da Câmara e do Senado, empurra o debate para um ano eleitoral, aumentando a incerteza regulatória e levantando questões cruciais: Por que o consenso falhou? Quais são os riscos de um vácuo legal prolongado? E, mais importante, o texto atual do PL 2338/2023 está, de fato, preparado para equilibrar proteção de direitos e o avanço da inovação no país?

O cenário político do adiamento: entre o consenso e a pressão eleitoral

O final do ano legislativo de 2025 foi marcado por uma intensa pressão para a aprovação do Marco Legal da IA. No entanto, a complexidade do tema, somada a um calendário esvaziado e a crises políticas internas, inviabilizou a conclusão da análise. O adiamento para a primeira semana de retomada dos trabalhos em 2026, embora busque manter a sensação de urgência, coloca o projeto em um ambiente de alta concorrência com pautas econômicas e o aquecimento do calendário pré-eleitoral .

O fator Redata: incentivos fiscais e o “casamento” legislativo

Um dos elementos mais notáveis do impasse político é a tentativa de atrelar o PL 2.338/2023 à Medida Provisória (MP) 1.318/25, que institui o Regime Especial de Tributação para a Atração de Data Centers (Redata). A MP, que prevê incentivos fiscais significativos para a infraestrutura digital, corria o risco de caducar por falta de votação.

A estratégia de “casar” o Redata com o Marco Legal da IA gerou um dilema. Enquanto o setor empresarial vê na manobra uma oportunidade de destravar investimentos e garantir vantagens econômicas, pressionando pela celeridade na aprovação do PL , especialistas alertam para o risco de acelerar a aprovação de uma regulação complexa sob pressão econômica, comprometendo o devido escrutínio de temas sensíveis e a qualidade do texto final. A inclusão de uma pauta de incentivo fiscal em um projeto de regulação de direitos e tecnologia demonstra como o debate sobre a regulação de IA no Brasil está intrinsecamente ligado a interesses econômicos e disputas de poder, desviando o foco da proteção social e da inovação equilibrada.

As críticas técnicas e o risco à inovação

O texto do PL 2.338/2023, que já passou pelo Senado e agora tramita na Câmara, tem sido alvo de críticas contundentes tanto do setor produtivo quanto da sociedade civil. O principal ponto de discórdia reside na sua abordagem regulatória, considerada por muitos como excessivamente rígida e inspirada no modelo europeu, sem a devida adaptação à realidade brasileira.

O dilema da regulação “ex ante” e o impacto em startups

Especialistas e representantes de empresas de Tecnologia da Informação (TI) defendem um modelo flexível de regulação para inteligência artificial, que adote uma abordagem assimétrica: quanto maior o risco da aplicação, maior a carga regulatória . A crítica central é que o PL, ao se aproximar de um modelo de compliance ex ante (regras impostas antes do uso), impõe uma carga regulatória desproporcional que pode sufocar a inovação, especialmente para startups e pequenas empresas.

A preocupação é que os altos custos de conformidade e a burocracia exigida para a avaliação de impacto algorítmico se tornem barreiras de entrada intransponíveis, beneficiando apenas as grandes big techs e “matando” as inovações locais . O executivo da Confederação das Associações das Empresas Brasileiras de Tecnologia da Informação (Assespro) chegou a afirmar que “não é trazendo modelo copiado da Europa que vai funcionar bem no Brasil” . Além disso, a exigência de compartilhar avaliações de impacto com autoridades reguladoras levanta o temor de exposição de informações estratégicas e sigilosas das empresas .

Lacunas e controvérsias: direitos, vieses e meio ambiente

A sociedade civil, por sua vez, aponta para lacunas e retrocessos no texto, que enfraquecem a proteção de direitos fundamentais .

Uma das maiores preocupações é a manutenção de um amplo rol de exceções para o uso de reconhecimento facial em segurança pública. Apesar de ser classificado como risco excessivo, as exceções criam um vácuo regulatório que permite o uso irrestrito da tecnologia por órgãos de persecução penal, sem salvaguardas efetivas.

Outro ponto de atenção é a insuficiência de medidas obrigatórias para prevenir e mitigar vieses discriminatórios. Dada a profunda desigualdade estrutural do Brasil, a falta de diretrizes claras pode fazer com que a IA perpetue e amplifique esses vieses, com impactos desproporcionais em populações vulneráveis .

Adicionalmente, a tramitação na Câmara resultou na retirada de salvaguardas mínimas para o mercado de trabalho . A automação e a adoção de sistemas de IA podem aprofundar a precarização em contextos de trabalho já vulneráveis, e o texto atual falha em proteger os trabalhadores. Por fim, o PL carece de regras substantivas sobre os impactos ambientais da cadeia produtiva da IA, ignorando o alto consumo de energia e recursos naturais (mineração) associados à tecnologia, limitando-se a menções genéricas .

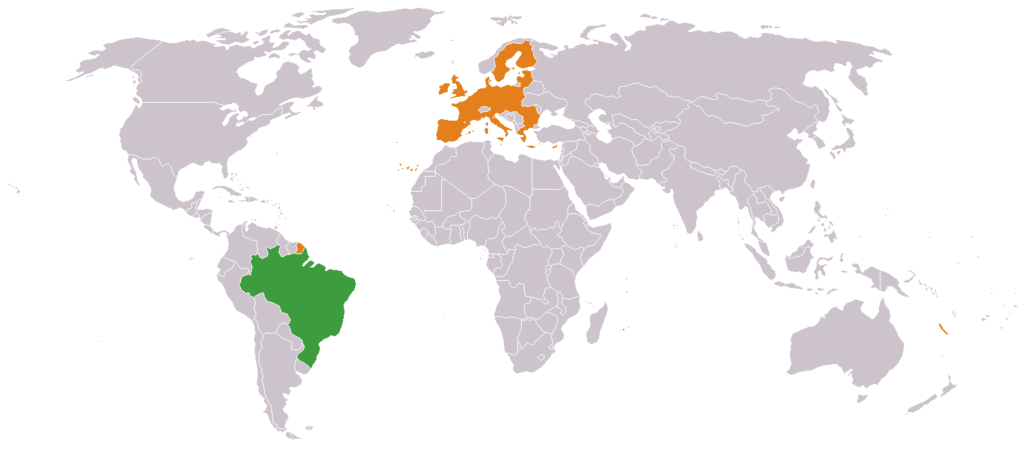

Brasil vs. União Europeia: o desafio de um modelo próprio

O PL 2.338/2023 é frequentemente comparado ao EU AI Act, a legislação europeia que se tornou referência global ao adotar uma abordagem baseada em risco. O projeto brasileiro compartilha a estrutura de classificação de risco (inaceitável, alto, baixo), mas a crítica de que ele é uma “cópia” mal adaptada persiste.

O Brasil, com sua vasta quantidade de dados (como os 175 milhões de usuários do PIX e 169 milhões de contas no gov.br), tem a oportunidade de se posicionar como uma potência em dados . O desafio, portanto, é criar um Marco Legal da IA que não apenas proteja direitos, mas que também use a regulação como um instrumento de fomento, garantindo que o compliance não se torne um entrave à competitividade e à inovação local. O Instituto de Tecnologia e Sociedade do Rio (ITS Rio) oferece uma análise comparativa detalhada das obrigações entre o PL 2.338/2023 e o EU AI Act .

Conclusão estratégica: o que o adiamento significa para o mercado

O adiamento da votação do Marco Legal da IA para 2026, embora frustrante para quem busca segurança jurídica, abre uma janela crucial para aprimoramento. O tempo extra deve ser utilizado para:

1.Qualificar o debate: Ampliar a participação social e técnica para refinar os pontos mais controversos, como a classificação de risco e as regras de compliance para startups.

2.Desvincular pautas: Separar a regulação de direitos e riscos (PL 2.338/2023, que pode ser consultado no site do Senado ) da pauta de incentivos fiscais (Redata), garantindo que cada tema seja analisado com a profundidade que merece.

3.”Tropicalizar” a regulação: Assegurar que o texto final adote um modelo de regulação assimétrica, que seja responsivo às rápidas mudanças tecnológicas e adaptado às desigualdades e à capacidade de inovação do mercado brasileiro.

A ausência de um marco regulatório claro em 2026, ano de eleições, é particularmente preocupante, pois aumenta o risco de uso indevido de IA, especialmente na disseminação de desinformação, sem que haja mecanismos legais de responsabilização e mitigação bem definidos. O mercado e a sociedade civil devem aproveitar este período de “pausa forçada” para pressionar por um texto que seja, de fato, um Marco Legal da IA equilibrado, inovador e justo.

Referências

[1] Votação do marco da inteligência artificial é adiado para 2026. Desinformante. Disponível em:

[5] PL 2338/2023. Senado Federal. Disponível em:

[6] Matriz comparada de obrigações: PL 2338/2023 vs. EU AI act. ITS Rio. Disponível em: